Über Sprachgrenzen hinweg: Meine Erfahrung mit KI-gestützter Kommunikation

stellt euch vor, eure Gedanken und Ideen könnten mühelos in jede Sprache übersetzt werden, sodass sie jeder auf der Welt verstehen kann. Genau das ist es, was ich kürzlich ausprobiert habe. Ich habe ein kurzes Video aufgenommen, in dem ich meine Vorträge über Künstliche Intelligenz vorstelle – eine Leidenschaft von mir, die ich gerne teilen möchte.

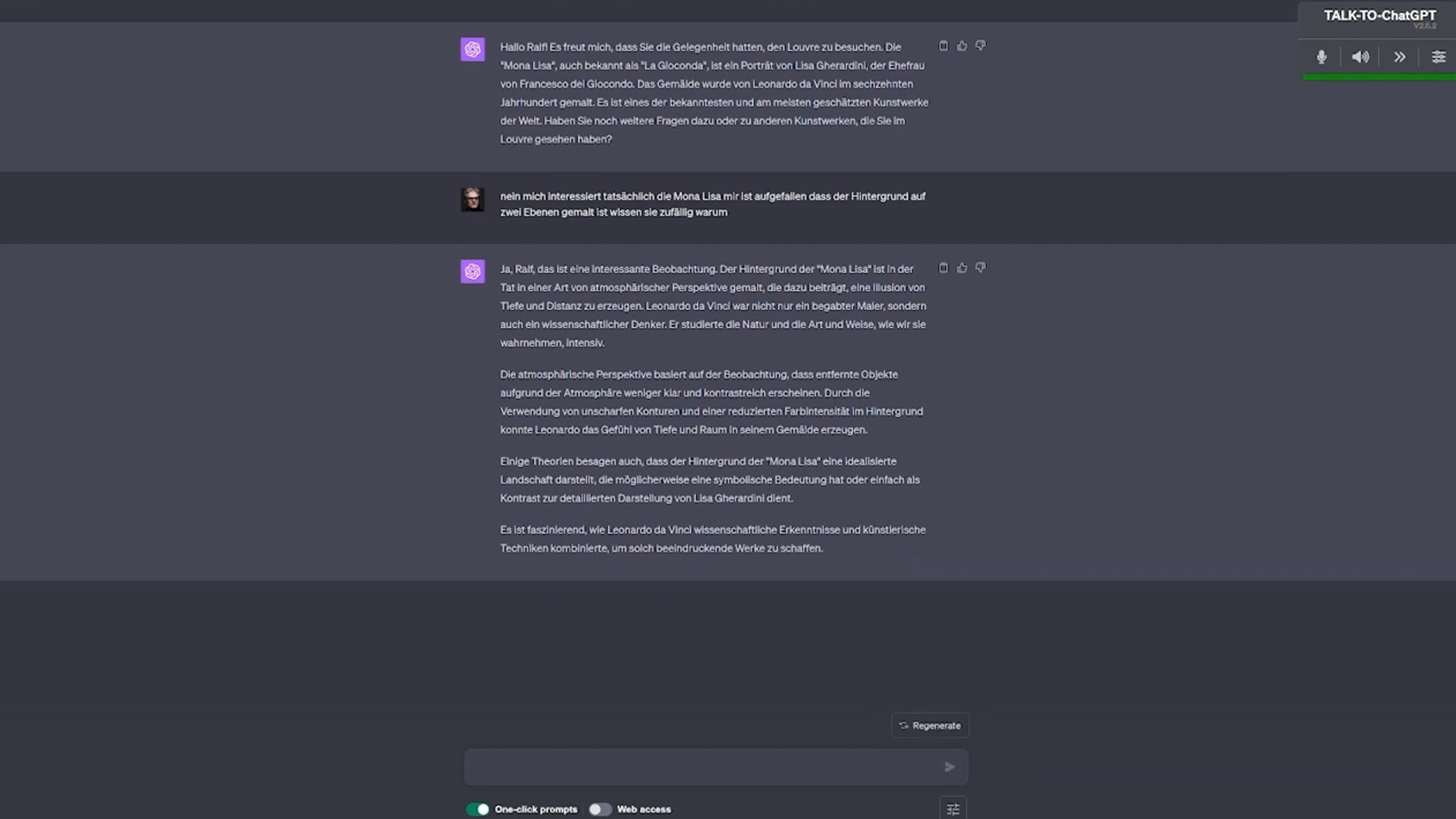

Mit Hilfe von Heygen-labs habe ich dieses Video in fünf verschiedene Sprachen übersetzen lassen: Niederländisch, Ukrainisch, Französisch, Englisch und Mandarin. Es war faszinierend zu sehen, wie meine Worte, meine Botschaften, in all diesen unterschiedlichen Sprachen, mit meiner Stimme wiedergegeben wurden.

Diese Erfahrung war nicht nur ein Experiment mit Sprachübersetzung; sie war ein Testlauf für eine Zukunft, in der Wissen und Expertise keine Grenzen kennen. Es war ein Beweis dafür, dass wir auf dem richtigen Weg sind, eine wirklich globale Gesellschaft zu werden.

Video in der Originalsprache Deutsch

Was bedeutet das nun für uns alle? Es zeigt, dass die Barrieren, die uns früher getrennt haben, allmählich verschwinden. Meine Versuche und Projekte mit KI sind nur ein kleines Beispiel dafür, was möglich ist, wenn wir diese Technologien nutzen, um einander besser zu verstehen und voneinander zu lernen.

In Mandarin

In Ukrainisch

In US Englisch

In Französisch

Neueste Kommentare