Interaktives Gespräch mit ChatGPT über Sprachschnittstelle

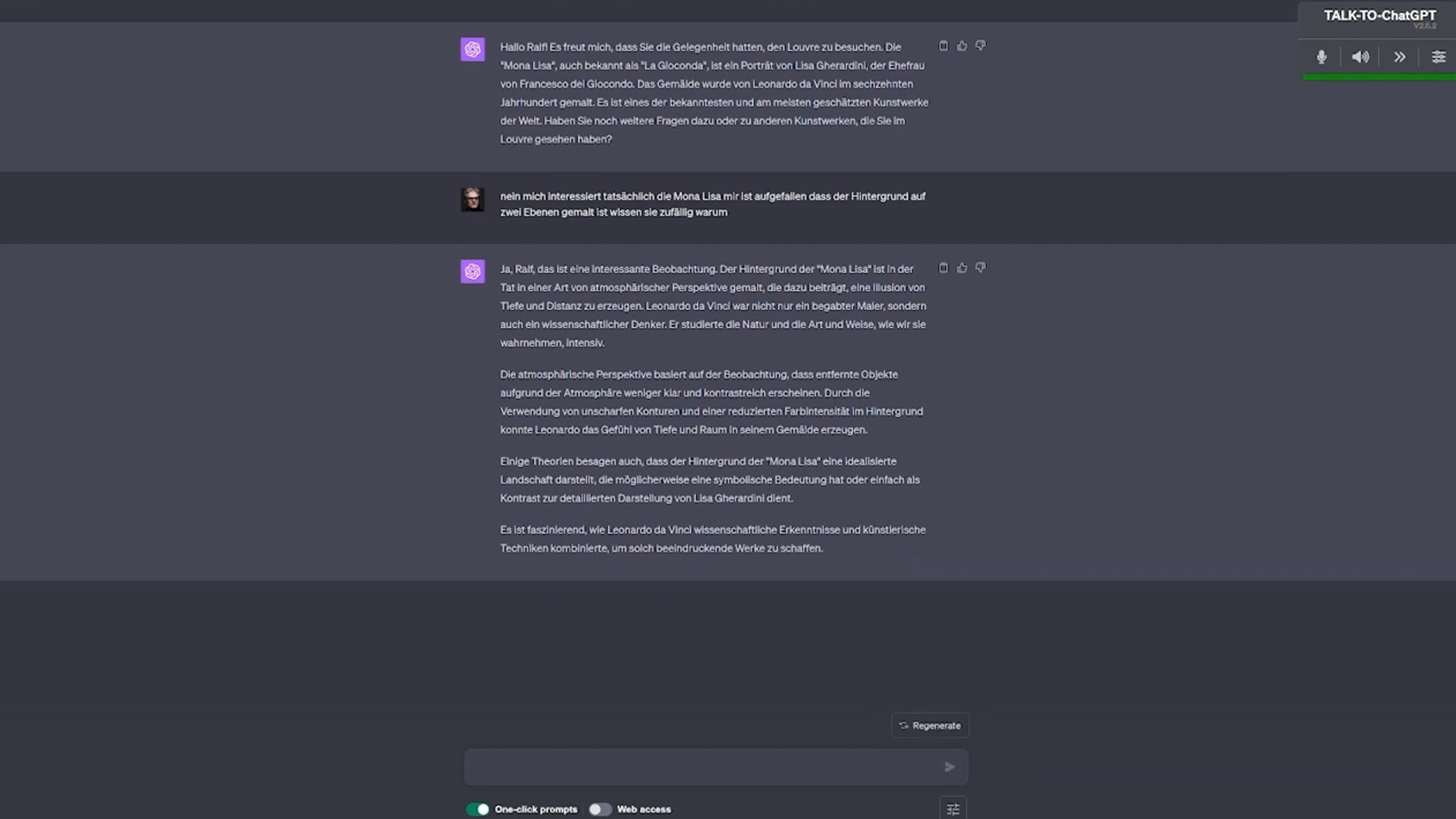

Kürzlich hatte ich die Gelegenheit, ein interessantes Gespräch mit ChatGPT zu führen. Dies war dank der Chrome-Erweiterung „Talk-to-GPT“ von GBAtemp und der Anbindung an den Sprachausgabe-Service von Elevenlabs.io möglich.

Die Erweiterung bietet, ähnlich wie bereits in Bing umgesetzt, eine Schnittstelle zum Mikrofon und zur Sprachausgabe. Um das Gespräch optimal zu gestalten, war es vorab wichtig, ChatGPT über den DAN-Modus (Do Anything Now) zu instruieren. Dadurch konnte ich dem Bot die Rolle eines Universitätsprofessors zuweisen, während ich selbst als Student auftrat, der ihm zufällig auf dem Flur begegnete.

Zusätzlich stellte sich die Vorgabe als sinnvoll heraus, dass Zahlen und Daten während der Sprachausgabe als Wörter ausgegeben werden sollten. Das Ergebnis war ein wirklich gelungenes, fließendes Gespräch.

Diese Erfahrung zeigt deutlich, wie weit die Entwicklung von KI-Sprachmodellen wie ChatGPT über bisherige Assistenten wie Alexa, Siri oder Google Assistant hinausgegangen ist. Ich bin überzeugt, dass solche Technologien im Unternehmenskontext, etwa bei Datenanalysen oder als Codeinterpreter, extrem hilfreich sein können.

Gleichzeitig hoffe ich, dass dies niemanden dazu verleitet, in ChatGPT einen neuen Gesprächspartner für abendliche Unterhaltungen zu suchen. Echte menschliche Interaktionen sind und bleiben dabei unersetzlich.

Neueste Kommentare